ERNIE-GeoL类别文心·跨模态大模型应用POI检索、POI推荐、POI信息处理、Geocoding等模型概述ERNIE-GeoL是『地理-语言』跨模态预训练大模型。为了有效建立并充分学习地理和语言之间的关联,ERNIE-GeoL在预训练数据构建、模型结构以及预训练目标三个方面进行了针对性的设计和创新。ERNIE-GeoL已经在百度地图POI检索、POI推荐、POI信息处理、地址解析、Geoc

免费申请测试 >> *价格优惠政策请联系客服咨询ERNIE-GeoL是『地理-语言』跨模态预训练大模型。为了有效建立并充分学习地理和语言之间的关联,ERNIE-GeoL在预训练数据构建、模型结构以及预训练目标三个方面进行了针对性的设计和创新。

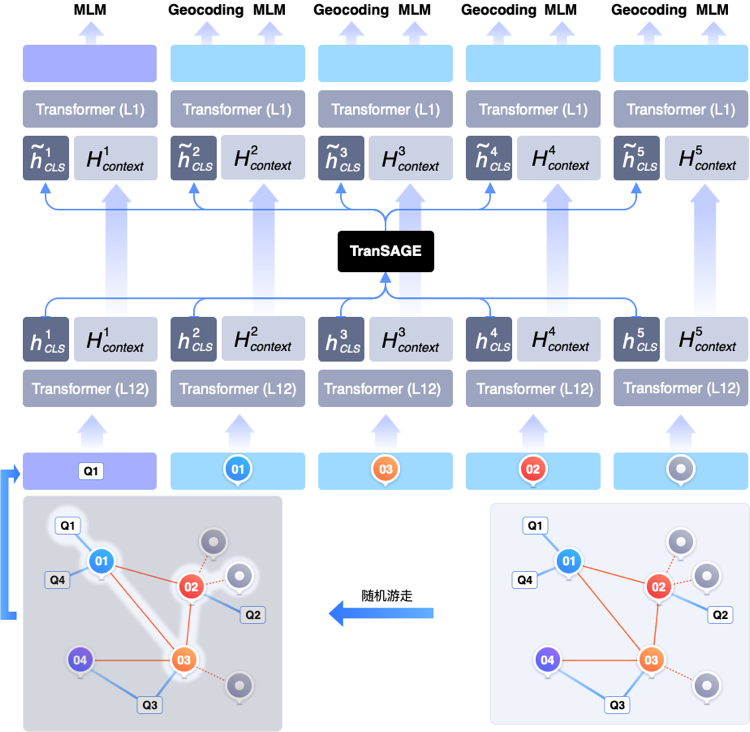

ERNIE-GeoL 以百度地图的用户搜索日志和 POI 数据库作为数据源,基于图桨 PGL(Paddle Graph Learning),利用其中蕴含的空间关系构建了异构图。如下图所示,该图由两种节点(POI 和查询)和以下三种不同类型的边构成:

为了让模型充分学习『地理位置-语言』间的关联,需要设计行之有效的预训练目标。为此,在用于学习地名知识的掩码语言模型(MLM)预训练任务之外,我们设计了用于学习文本与地理坐标关联的 Geocoding(GC)预训练任务。

ERNIE-GeoL

类别文心·跨模态大模型

应用POI检索、POI推荐、POI信息处理、Geocoding等

模型概述

ERNIE-GeoL是『地理-语言』跨模态预训练大模型。为了有效建立并充分学习地理和语言之间的关联,ERNIE-GeoL在预训练数据构建、模型结构以及预训练目标三个方面进行了针对性的设计和创新。ERNIE-GeoL已经在百度地图POI检索、POI推荐、POI信息处理、地址解析、Geocoding等业务中应用落地,大幅提升了这些任务的效果。

模型说明

ERNIE-GeoL 以百度地图的用户搜索日志和 POI 数据库作为数据源,基于图桨 PGL(Paddle Graph Learning),利用其中蕴含的空间关系构建了异构图。如下图所示,该图由两种节点(POI 和查询)和以下三种不同类型的边构成:

起点-到-终点,表示的是用户对两个地点的访达,蕴含了丰富的空间移动信息。

POI-共同出现-POI,表示共同出现在同一个地块内的两个 POI,蕴含了空间共现信息。

查询-点击-POI,来自于用户的地点查询日志,蕴含了丰富的地名和空间关系知识。

在此异构图的基础上,我们使用随机游走算法自动化地生成大量节点序列作为预训练数据。

以上述方式构建的数据蕴含了丰富的地理知识。为了更有效地从中学习地理知识,需要对其中的图结构进行充分建模。为此,我们在设计 ERNIE-GeoL 的模型结构(详见下图)时,专门引入了一个 TranSAGE 聚合层,用于充分学习训练数据中的图结构,同时将不同模态的数据映射到统一的表示空间。TranSAGE 层使用多头注意力机制对每个节点的不同表示进行聚合,具体细节可参考https://arxiv.org/abs/2203.09127。

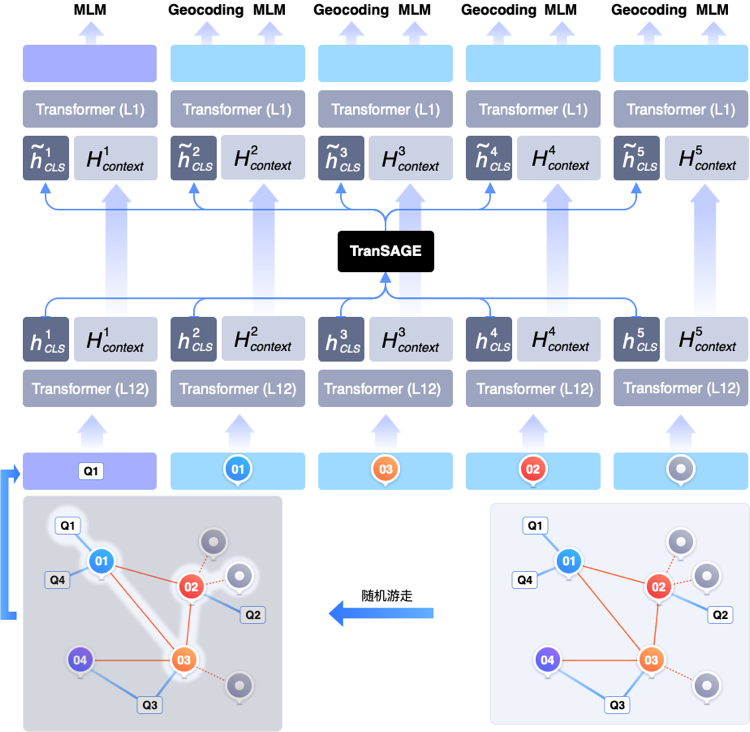

为了让模型充分学习『地理位置-语言』间的关联,需要设计行之有效的预训练目标。为此,在用于学习地名知识的掩码语言模型(MLM)预训练任务之外,我们设计了用于学习文本与地理坐标关联的 Geocoding(GC)预训练任务。

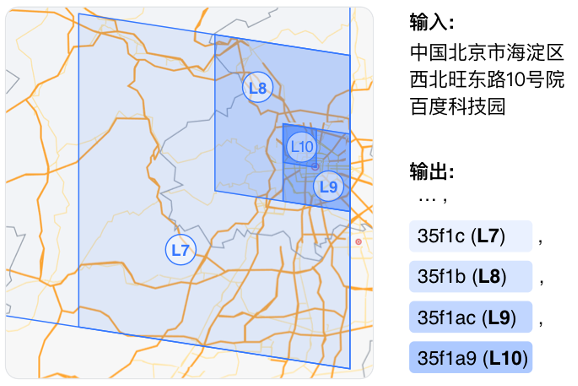

下图给出了该任务的一个示例,我们将百度科技园所在的不同层级的地块(L7 至 L10)表示成前缀互有关联的 token(35f1c 至 35f1a9)。我们利用 s2 地块编码方式获取其对应的 token。依托 s2 地块编码多级覆盖特性,在训练的过程中,我们使模型按预测地块编码中每一个字符的方式一次性的预测出多个层级的地块表示。按这种方式,模型利用注意力机制可以学习到输入中描述不同层级地理概念的文本(如北京市、海淀区、西北旺东路 10 号、百度科技园)和不同层级(如 L7、L8、L9、L10)的地理编码的映射关系,从而使模型充分且高效地学习文本与地理坐标的关联,加强模型在处理不完整或不规范地理描述文本时的鲁棒性。具体训练方式详见https://arxiv.org/abs/2203.09127。

为了验证 ERNIE-GeoL 在地理位置相关任务上的应用效果,我们选取了 5 个地图业务中的常见任务(详见表 1),包括:

POI 检索业务中的 query 意图识别(Query IntentClassification)任务;

POI 检索业务中的 query-POI 匹配(Query-POIMatching)任务;

POI 推荐业务中的下一个 POI 推荐(Next POI Recommendation)任务;

POI 信息处理业务中的地址解析(Address Parsing)任务;

POI 信息处理业务中的地理编码(Geocoding)任务。

表 2 显示了各个模型在上述 5 个任务上的评测结果。从评测结果中可以看出,ERNIE-GeoL 在各个任务上的效果,均显著超过了其他通用预训练语言模型。

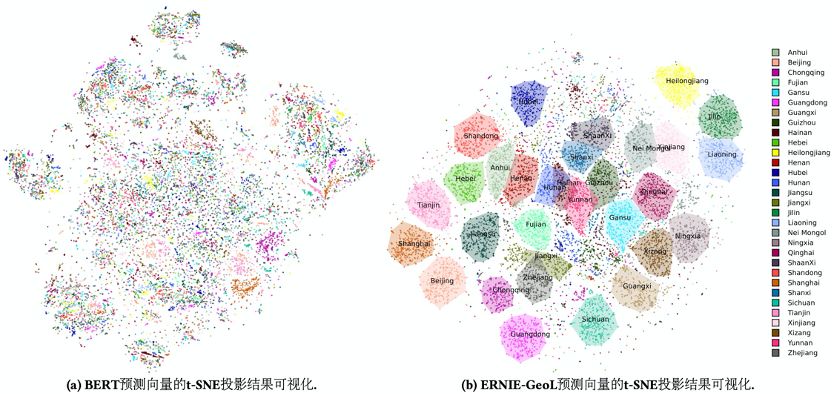

首先,我们选取中国除港澳台以外的 31 个省级行政区划中检索热度 top 500 的 POI。基于这些 POI 的名字和地址,通过不同预训练模型获得与之对应的 embeddings 后,再利用 t-SNE 算法将得到的 embeddings 进行降维。结果如下图所示,从中我们可以看出,通用的预训练语言模型 BERT 无法将位于同一省份的 POI 聚在一起。与之形成鲜明对比的是,“地理位置-语言”预训练模型 ERNIE-GeoL 能够很好地将位于相同省份的 POI 聚在一起。同时,在现实世界中临近的省份在图中也相邻,如图中右上角的黑吉辽三省。

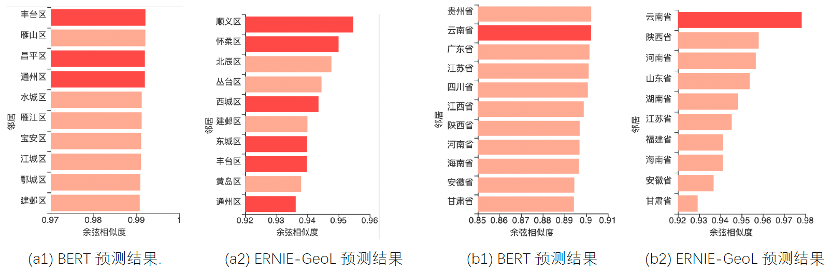

其次,借鉴著名的“king – man + woman queen”类比示例,我们也设计了两个类比示例来验证 ERNIE-GeoL 对于地理类比关系的学习效果(见下图)。示例 a 用来测试模型是否学习到了“一个城市的下级行政区划”的关系。我们首先将查询设置为“黄埔区-上海+北京”,候选设置为所有中国城市的下级区域名称。然后用预训练模型将查询和候选分别表示为向量并计算各个候选向量和查询向量之间的余弦相似度。图 a1,a2 分别展示了 BERT 和 ERNIE-GeoL 预测结果中余弦相似度排名前 10 的候选。从中可以看出,ERNIE-GeoL 召回的正确区域比 BERT 多出一倍。类似的,我们设计了另一个示例来测试模型是否学习到了“一个省的省会”的关系。在该测试中,查询设置为“广东省-广州+昆明”,候选设置为所有中国省级行政单位的名称。如图 b1,b2 所示,ERNIE-GeoL 以最高的相似度得分输出了正确的目标省份“云南省”。此外,在这两幅图中,与 ERNIE-GeoL 预测的结果相比,BERT 预测结果的余弦相似度得分间的区分度较低。上述两个定性分析的结果表明 ERNIE-GeoL 在一定程度上学会了不同地理实体之间的空间关系和语义关系。

ERNIE-GeoL 通过地图数据自动化地构建了蕴含地理知识的大规模预训练数据,并使用专门设计的网络结构和相匹配的预训练目标对地理知识进行了充分的学习。定量实验中的显著效果提升和定性实验中的差异化结果,表明我们所提出的“地理位置-语言”预训练模型 ERNIE-GeoL 能够显著提升地理位置相关任务的效果并在具有广泛的应用落地潜力。

百度地图开放平台现已提供 GC ERNIE-GeoL 版开放使用。 GC ERNIE-GeoL 版是融入了百度“地理-语言”预训练大模型文心 ERNIE-GeoL 能力的地理编码(GC)升级版,大幅显著提升了解析准确率,能够更好满足智慧物流、智慧城市等行业地址解析高准确率的需求。 具体服务请扫码体验:

微信公众号

手机站

COPYRIGHT 2007-2020 TUIDC ALL RIGHTS RESERVED 腾佑科技-百度AI人工智能_百度人脸识别_图像识别_语音识别提供商

地址:河南省郑州市姚砦路133号金成时代广场6号楼13层 I CP备案号:豫B2-20110005-1 公安备案号: 41010502003271

声明:本站发布的内容版权归郑州腾佑科技有限公司所有,本站部分素材来源于网络及网友投稿,若无意中侵犯了您的版权,请致电在线客服我们将在核实后予以删除!