百度飞桨集深度学习核心框架、模型库、开发套件、工具组件于一体,是中国首个自主研发、功能丰富、开源开放的产业级深度学习平台;预装飞桨企业版BML,内置百度超大规模预训练模型和飞桨模型库,提供模型开发与推理预测全流程功能支撑

全面支持语音、图像、NLP模型的训练、推理;通用版配置Nvidia Tesla T4或Nvidia Tesla A100加速卡;信创版配置百度自研昆仑AI加速卡,同时可扩展支持昇腾、寒武纪、比特大陆等国内主流AI加速卡

预置飞桨算法库和超大规模预训练模型,与芯片深度适配,支撑多场景高效应用;推理服务实现与20+国内外芯片与硬件适配,提供完备的模型端到端部署能力

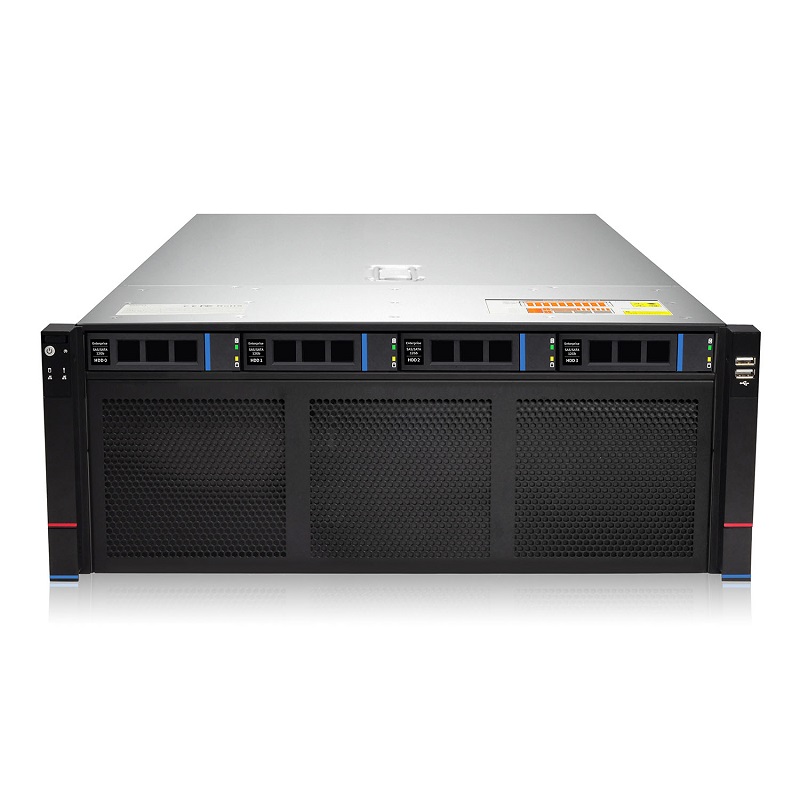

整机配置Nvidia Tesla A100/Nvidia Tesla T4 GPU,满足训练和推理的不同应用场景;使用Intel CascadeLake系列CPU,配有内置英特尔®Deep Learning Boost,可针对AI工作负载提供高性能推断处理;模型训练和预测场景可通过vGPU技术提高资源利用率,vGPU支持显存隔离和共享调度,可按任意比例和数值进行隔离。

数据管理、模型训练、模型管理、推理预测、运维管理,配置A100高性能GPU算力Nvidia Tesla A100-40G-PCIE高性能GPU算力;2/4/8卡灵活配比满足不同规模业务需求

数据管理、模型训练、模型管理、推理预测、运维管理,配置T4高性价比GPU算力Nvidia Tesla T4-16G-PCIE高性价比GPU算力;2/4/8卡灵活配比满足不同规模业务需求

模型管理、推理预测、运维管理,配置T4高性价比GPU算力Nvidia Tesla T4-16G-PCIE高性价比GPU算力;2/4/8卡灵活配比满足不同规模业务需求

全面适配飞腾、鲲鹏等主流CPU处理器和麒麟、统信等国内操作系统;集成百度自研昆仑AI加速卡,同时可扩展支持昇腾、寒武纪、比特大陆等国内主流AI加速卡;内置飞桨企业版BML全功能AI开发平台,具有自主研发、功能全面、技术领先、开箱即用等核心优势。

数据管理、模型训练、模型管理、推理预测、运维管理

1)最多支持2块全高全长双宽AI加速卡;

2)集成百度自研昆仑AI加速卡,同时可扩展支持昇腾、寒武纪、比特大陆等国内主流AI加速卡;

3)内置50+与芯片深度适配的算法模型,精度无损的情况下其推理性能持平或优于Tesla T4,可支撑多场景高效应用

数据管理、模型训练、模型管理、推理预测、运维管理

1)2/4/8卡灵活配比;

2)最多支持8块全高全长双宽AI加速卡;

3)集成百度自研昆仑AI加速卡,同时可扩展支持昇腾、寒武纪、比特大陆等国内主流AI加速卡;

4)内置50+与芯片深度适配的算法模型,精度无损的情况下其推理性能持平或优于Tesla T4,可支撑多场景高效应用

百度飞桨集深度学习核心框架、模型库、开发套件、工具组件于一体,是中国首个自主研发、功能丰富、开源开放的产业级深度学习平台;预装飞桨企业版BML,内置百度超大规模预训练模型和飞桨模型库,提供模型开发与推理预测全流程功能支撑

全面支持语音、图像、NLP模型的训练、推理;通用版配置Nvidia Tesla T4或Nvidia Tesla A100加速卡;信创版配置百度自研昆仑AI加速卡,同时可扩展支持昇腾、寒武纪、比特大陆等国内主流AI加速卡

高可靠CPU与AI加速卡异构融合;基于国内外主流CPU架构,可配置2/4/8块AI加速卡,支持多种数据精度的训练和推理

预置飞桨算法库和超大规模预训练模型,与芯片深度适配,支撑多场景高效应用;推理服务实现与20+国内外芯片与硬件适配,提供完备的模型端到端部署能力

客户服务分级和问题分类,提供7×24小时1对1电话支持服务,根据故障情况以最快的方式协调资源提供远程或现场支持。

与硬件生产厂商保持高度战略协作,对于需求评估、计划及订单管理等方面拥有丰富经验,核心组件提供三年现场服务,非核心硬件故障,提供送修服务。

提供远程或现场平台软件安装部署服务、产品软件升级服务、软件使用问题咨询、系统巡检服务、故障问题现场处理支持服务、产品培训服务

产品交付采用专项专人管理机制。专业的项目管理人才和团队,丰富的项目实施交付经验,保障项目完整顺利交付。

微信公众号

手机站

COPYRIGHT 2007-2020 TUIDC ALL RIGHTS RESERVED 腾佑科技-百度AI人工智能_百度人脸识别_图像识别_语音识别提供商

地址:河南省郑州市姚砦路133号金成时代广场6号楼13层 备案号: 豫B2-20110005-1

声明:本站发布的内容版权归郑州腾佑科技有限公司所有,本站部分素材来源于网络及网友投稿,若无意中侵犯了您的版权,请致电在线客服我们将在核实后予以删除!